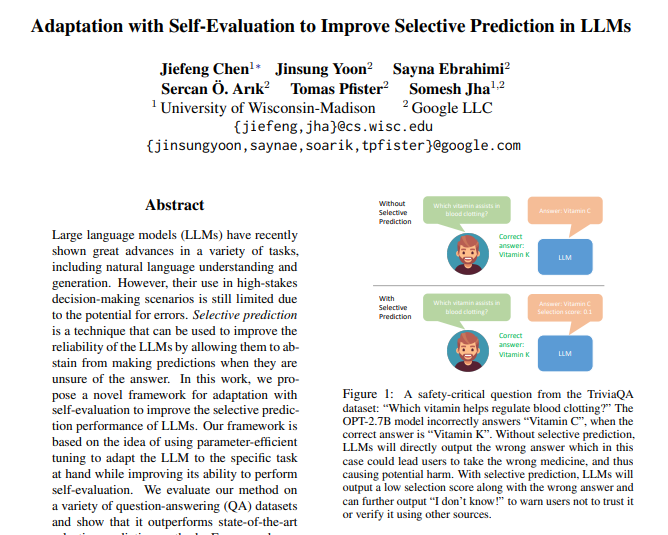

2月7日 消息:谷歌最近推出了一项名为ASPIRE的自适应评估框架,旨在帮助大型语言模型在面对置信度较低的样本时做出正确的判断。这个框架的核心技术思路是基于自我评估的选择性预测,通过任务定向微调、答案采样和自我评估学习三大模块来实现。

论文地址:https://aclanthology.org/2023.findings-emnlp.345.pdf?ref=maginative.com

具体来说,任务定向微调能够通过使用目标任务的训练数据对模型进行微调,提高其在特定任务上的性能。答案采样则可以生成多个候选答案,并评估其概率分布,以帮助模型判断答案的可靠性。自我评估学习则通过学习自我评估能力,让模型能够更好地区分正确和错误答案,从而提高选择性预测性能。

实验数据显示,ASPIRE在不同数据集上均表现出了良好的性能。例如,在CoQA数据集上,ASPIRE框架将答案的准确性提升了,并且能够减少错误答案的生成;在TriviaQA数据集上,通过设置选择性分数阈值,ASPIRE能够更准确地判断出哪些问题的答案不可靠,从而避免生成错误答案;在Natural Questions数据集上,ASPIRE成功降低了错误答案的比例,提高了答案的质量。这些实验证明了ASPIRE框架的高效性和可行性,为大型语言模型的应用提供了重要的支持和保障。

ASPIRE框架的推出填补了大型语言模型在置信度校准方面的空白,为其在实际应用中的稳定性和准确性提供了有力保障。随着这一框架的不断完善和应用,相信大型语言模型在各个领域的表现将会更加出色,为人们带来更好的体验和服务。