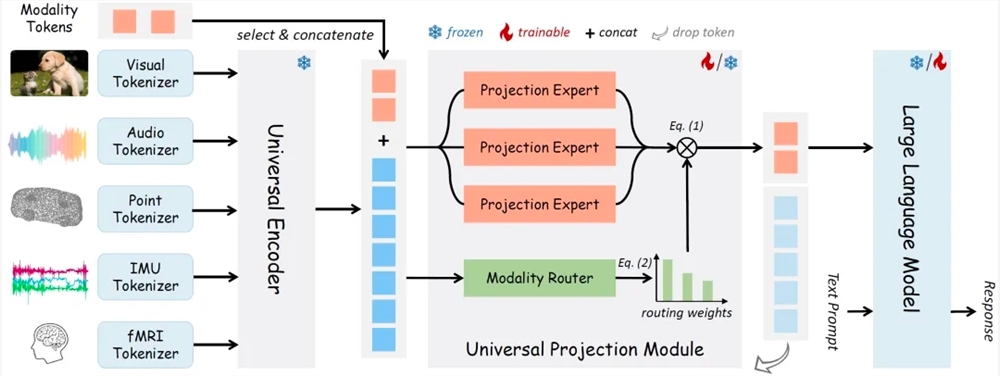

12月22日 消息:OneLLM 是一种多模态对齐的统一框架,它使用通用编码器和统一的投影模块与 LLM(Large Language Model)对齐多模态输入。OneLLM 还通过使用 modality tokens 实现了在不同模态之间的切换。

OneLLM 的核心组件包括多模态 token 的 tokenizer、通用编码器、统一的投影模块和大语言模型。

多模态 token 的 tokenizer 将输入的各种模态信号转换为 token 序列,以便进行后续处理和对齐。

通用编码器是在 LAION(Language and AI ON)平台上训练的 CLIP VIT Large 模型,它具有强大的语义理解能力,可以对多模态输入进行编码。

统一的投影模块(UPM)是将各个模态的输入投影到 LLM 的 embedding 向量空间中,以实现多模态的对齐。UPM 由 K 个投影专家组成,每个专家包含多个 transformers 块和大量的参数。

大语言模型是 OneLLM 采用的开源 LLaMA2-7B 模型,它在大规模文本数据上进行了预训练,可以对输入进行更深入的语义理解和生成。

OneLLM 支持多种不同模态数据的理解,包括图像、音频、视频、点云、深度 / 法线图、IMU 和 fMRI 大脑活动。

实验证明,OneLLM 在视频 - 文本、音频 - 视频 - 文本、音频 - 文本等任务中优于现有方法,表现出了较强的零样本能力。

Github代码链接:

https://github.com/csuhan/OneLLM

模型权重链接:

https://modelscope.cn/models/csuhan/OneLLM-7B

模型创空间:

https://modelscope.cn/studios/csuhan/OneLLM