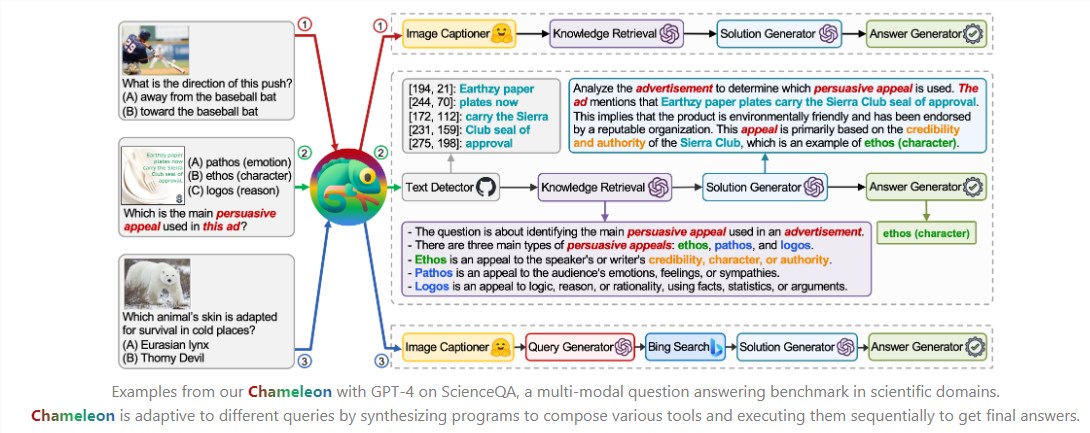

12月12日 消息:在NeurIPS2023上,UCLA等机构发布的Chameleon框架吸引了广泛关注。该框架通过融合多种工具,包括LLMs、视觉模型、搜索引擎、Python功能及基于规则的模块,解决了大型语言模型在实时信息获取和数学推理方面的不足。

Chameleon的核心在于通过LLM规划器生成自然语言程序,找到最佳工具组合,以达到精确推理的目的。该框架在科学问答任务和表格数学推理任务上表现卓越,特别是在表格数学推理任务上,准确率达到了惊人的98.78%。

项目地址:https://chameleon-llm.github.io/

Chameleon的灵感来源于变色龙,象征着大型语言模型在执行外部工具组合推理任务时的多功能性和适应性。与其他工作相比,Chameleon在工具多样性和调用灵活性方面具有显著优势。

其工具箱支持LLM模型、视觉模型、网络搜索引擎、Python函数以及基于规则的模块,实现了多种工具之间的自然语言通信。相较于现有工作,Chameleon模型允许以类似自然语言的方式生成不同工具的调用组合,无需复杂的程序设计,增加了用户友好性。

Chameleon模型由工具箱和LLM规划器构成,工具箱包含各种技能的工具,如图像理解、知识理解、数学推理、表格推理和问答。LLM规划器基于大型语言模型,通过提示学习和语境学习能力,生成自然语言形式的程序,从而实现对工具箱中的工具进行组合和调用。Chameleon模型的评测表现在多模态推理任务上进行,如科学问答和表格数学推理,取得了令人瞩目的成绩。

Chameleon框架在多工具融合、自然语言程序生成和多模态推理任务上展现出卓越的性能,为大型语言模型在复杂任务中的应用提供了新的思路和解决方案。其灵活性、适应性和用户友好性使其在学术界和开发者社区中受到瞩目。