12月12日 消息:在 Meta AI 的一项开创性研究中,研究人员成功解决了动态3D 头像的高保真重新调整光线的挑战。传统方法在实时应用中捕捉面部表情的细节常常需要进行改进,尤其是对于捕捉亚毫米级细节的要求。Meta AI 的研究团队针对这一挑战提出了 “可重新调整光线的高斯编码头像(Relightable Gaussian Codec Avatars)”,这一方法有望重新定义头像的逼真程度。

这项研究团队解决的核心问题是如何更清晰地捕捉动态面部序列中的亚毫米级细节,例如头发和毛孔。现有方法的局限性促使人们寻求一种能够在保持实时性的同时,高效地建模人类头部多样材料(包括眼睛、皮肤和头发)并容纳所有频率反射的创新解决方案。

现有的可重新调整光线头像方法一直面临着实时性和真实性之间的折衷。在实时应用中捕捉动态面部细节一直是一个持久的挑战。Meta AI 的研究团队认识到了这一差距,并提出了 “可重新调整光线的高斯编码头像” 作为一种革命性的解决方案。

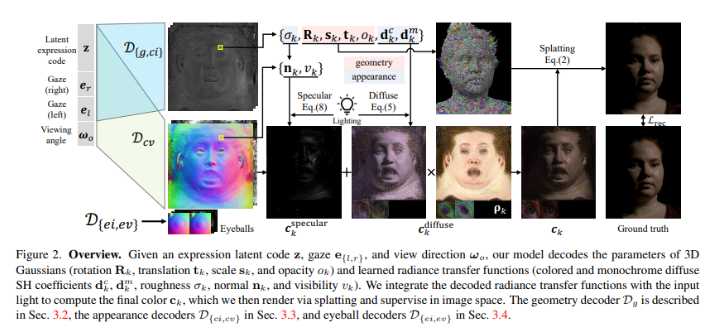

Meta AI 的方法引入了基于3D 高斯函数的几何模型,提供了亚毫米级精度的准确性。这在捕捉动态面部序列方面是一个显著的进步,确保头像展示出逼真的细节,包括头发和毛孔的微妙之处。作为这种创新方法的关键组成部分,可学习的辐射转移外观模型构建了可重新调整光线的外观模型。

这些头像的亮点在于其全面的头像构建方法。以3D 高斯函数为参数的几何模型是头像的支撑,使得头像能够使用高斯扩散技术进行高效渲染。由可学习的辐射转移驱动的外观模型结合了漫反射球谐函数和镜面高斯函数,使得头像能够进行点光源和连续光照的实时重新调整。

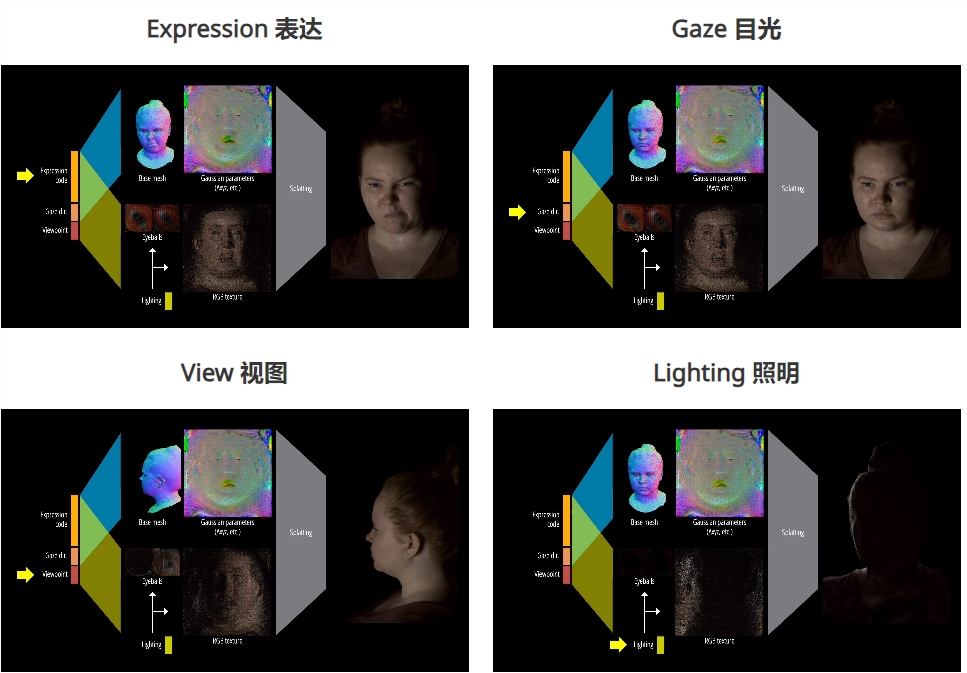

除了这些技术方面,该方法引入了对表情、视线、观察角度和光线的可分离控制。通过利用潜在表情代码、视线信息和目标视角方向,可以实现头像的动态动画。这种控制水平是头像动画的重大进步,为用户提供了细腻而互动的使用体验。

这些头像不仅仅是理论上的进步,它们也提供了切实可行的结果。该方法允许对各个方面进行可分离的控制,通过头戴相机进行实时视频驱动动画的演示。这种能力创造了动态、互动的内容,实时视频输入可以无缝驱动头像。

Meta AI 的 “可重新调整光线的高斯编码头像” 标志着创新在解决复杂问题方面的巨大威力。通过将基于3D 高斯函数的几何模型与革命性的可学习辐射转移外观模型相结合,研究团队超越了现有方法的局限,为头像的逼真程度树立了新的标准。

论文网址:https://arxiv.org/abs/2312.03704

项目网址:https://shunsukesaito.github.io/rgca/