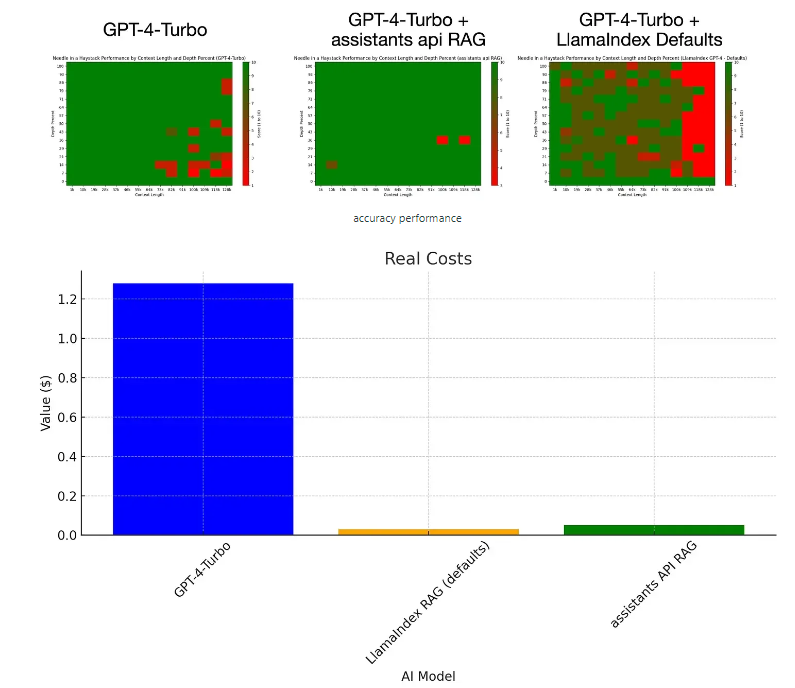

12月8日 消息:近期的“大海捞针”实验揭示了RAG+GPT-4Turbo模型的卓越性能,只需4%的成本,便能在生成响应时实现卓越的准确性。这标志着大型模型领域的一次重要突破。

在这个实验中,研究者使用了三种基本技术,包括上下文窗口填充、RAG(检索增强生成)和微调,以使LLM在不同情境下生成超具体的响应。

在实验中,RAG模型表现出色,尤其是在搜索式查询方面,其性能接近完美。这与传统的上下文窗口填充相比,展示了RAG在处理文本时的显著优势。

成本方面,RAG的每个token成本仅为GPT-4Turbo的4%,为模型性能提供了高性价比。此外,作者还对不同RAG管道进行了基准测试,结果显示在特定情境下,不同的RAG实现可能存在一些差异。

对于延迟方面,RAG通常是针对离线数据进行的,但研究者也比较了在线RAG的端到端延迟时间。结果显示,即使是在线RAG的延迟也可以与离线数据相媲美,这为实际应用提供了更多可能性。此外,通过对“大海捞针”实验的深入分析,研究者强调了RAG技术的优越性,尤其是在处理大规模上下文时,相比于传统上下文窗口填充。

这一研究揭示了RAG+GPT-4Turbo模型在大型语言模型领域的突破性进展。通过合理的成本和出色的性能,RAG模型为未来的LLM应用打开了新的可能性,为生成超具体、个性化响应的应用提供了强大的支持。这一技术创新不仅有望推动自然语言处理领域的发展,也为更广泛的人工智能应用带来了新的可能性。