11月13日 消息:在最新的AI模型和研究领域,一种名为Latent Consistency Models(LCMs)的新技术正迅速推动文本到图像人工智能的发展。与传统的Latent Diffusion Models(LDMs)相比,LCMs在生成详细且富有创意的图像方面同样出色,但仅需1-4步骤,而不是数百步骤。这一创新正在为文本到图像AI迈向重要的飞跃。

LCMs的突破在于极大地减少了生成图像所需的步骤。相比于LDMs数百步骤的费时生成,LCMs在仅需1-4步骤的情况下达到了相似的质量水平。这一高效性是通过将预训练的LDMs精炼成更加简化的形式实现的,从而大大降低了计算资源和时间的需求。

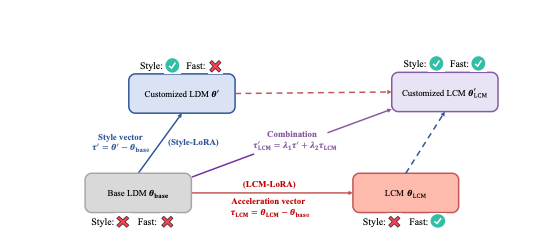

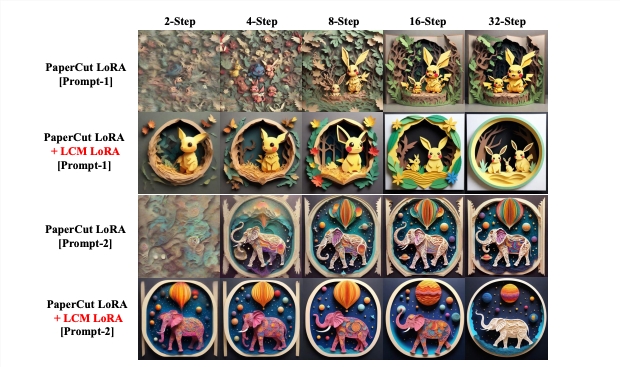

在介绍了LCM模型的论文中还提到了一项创新,即LCM-LoRA,这是一种通用的稳定扩散加速模块。该模块可以直接插入各种稳定扩散微调模型中,无需额外的训练。这成为人工智能驱动的图像生成中的一种潜在工具,能够加速多样化的图像生成任务。

在论文中,研究团队通过一种称为“蒸馏”的巧妙方法来高效地训练LCMs。他们首先在文本与图像配对的数据集上训练了标准的Latent Diffusion Model(LDM),然后利用其生成的新训练数据来训练Latent Consistency Model(LCM)。这种蒸馏过程使得LCM能够从LDM的能力中学习,而无需在庞大的数据集上从头训练。这一过程的高效性体现在研究者仅用单个GPU在约32小时内成功训练出高质量的LCMs,远远快于以往的方法。

研究结果展示了LCMs在图像生成AI方面的重大进展。LCMs能够在仅4步的情况下创建高质量的512x512图像,相较于Latent Diffusion Models(LDMs)数百步的要求,是一项显著的改进。这些模型不仅轻松处理较小图像,而且在生成大型1024x1024图像方面表现出色,展示了它们适应较大神经网络模型的能力。

然而,当前LCMs的一个主要限制是两阶段训练过程,首先训练LDM,然后使用它来训练LCM。未来研究可能会探索更直接的LCMs训练方法,有可能避免使用LDM。此外,论文主要探讨了无条件图像生成,对于文本到图像合成等有条件生成任务,可能需要更多工作。

Latent Consistency Models代表了文本到图像快速、高质量生成的重大进步。这些模型在仅1-4步的情况下就能够产生与较慢LDMs相媲美的结果,有望彻底改变文本到图像模型在实际应用中的应用。

虽然目前还存在一些限制,特别是在训练过程和生成任务范围方面,但LCMs标志着基于神经网络的图像生成迈出了重要一步。与LoRA结合的LCM-LoRA模型则为高效生成高质量、风格特定图像提供了通用解决方案,具有广泛的实际应用潜力,从数字艺术到自动化内容创建都可能迎来颠覆性的革新。