11月9日 消息:最新研究警告,大型模型在基准评估中可能面临潜在危害,原因是测试集中的数据可能意外进入预训练过程。这项研究由中国人民大学信息学院、高瓴人工智能学院和伊利诺伊大学厄巴纳-香槟分校的学者联合进行。

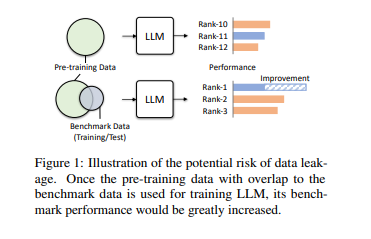

研究发现,由于预训练语料包含大量公开文本,而评估基准建立在这些信息之上,大型模型在实际应用中可能产生潜在的危害。

论文地址:https://arxiv.org/pdf/2311.01964.pdf

在多项模拟测试中,研究人员发现当大型模型的预训练数据中包含某个评测基准的数据时,其在该基准中表现更好。然而,在其他常识和数学基准中,模型的表现下降。甚至在没有泄露数据的任务中,模型的表现也受到影响并下降。

研究团队分析了这种训练数据泄露情况可能性,指出大型模型的预训练语料和基准测试数据都采用公开文本,导致数据重叠在所难免。当前的模型评估方式难以严格检查异常数值提升,而大型模型的预训练语料被视为核心机密,外界无法评估,造成模型意外“投毒”。

为规避这一问题,研究团队提出了一些建议。首先,建议大型模型应采用多个基准测试,尽管在实际情况中完全避免数据重叠很难。其次,对基准测试维护人员,应提供基准测试数据来源,分析数据被污染的风险。然而,研究团队也承认本次研究存在一定局限,未对不同程度的数据泄露进行系统性测试。

该研究的发现对评估大型模型在各种基准测试中的表现提出了重要警示,并为未来的研究提供了有价值的参考。这项研究由中国人民大学信息学院、高瓴人工智能学院和伊利诺伊大学香槟分校的学者联合完成,其中包括两位数据挖掘领域的专家:文继荣和韩家炜。文继荣教授分别是中国人民大学高瓴人工智能学院院长和中国人民大学信息学院院长,而韩家炜教授是伊利诺伊大学香槟分校计算机系教授,同时也是美国计算机协会院士和IEEE院士。

这一研究呼吁关注大型模型的基准评估问题,强调在评估过程中需要更多的透明度和多样性。对于未来的研究,需要进一步探讨不同程度的数据泄露对模型性能的影响,并在预训练中引入数据泄露进行更深入的模拟测试。