10月25日 消息:Stability AI Japan最近发布了两款令人瞩目的日语语言模型,分别命名为“Japanese Stable LM3B-4E1T”和“Japanese Stable LM Gamma7B”。

前者具有大约30亿参数,而后者则拥有高达70亿参数的庞大规模。这两款模型以Apache2.0许可证发布,允许商业使用,为日本的自然语言处理领域带来了一次革命性的突破。

这两个模型的背景可追溯到之前发布的英语语言模型,具体为“Stable LM3B-4E1T”和“Mistral-7B-v0.1”。最初,它们在主要使用英语数据进行训练,因此在英语处理方面表现出色,但在日语处理能力上受限,这是因为日语数据相对较少。

为了提高其日语语言能力,这两个模型经历了持续的预训练,利用了来自维基百科、mC4、CC-100、OSCAR和SlimPajama(不包括Books3)等数据源的大约1000亿token。

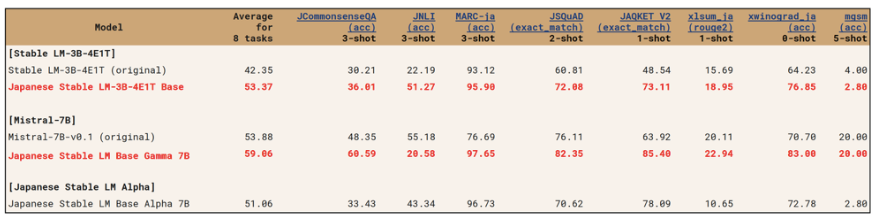

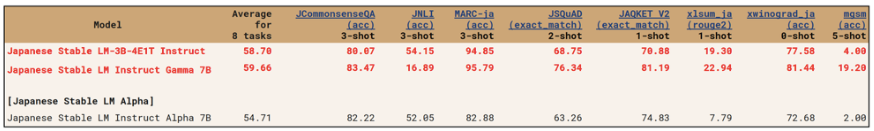

这两款模型的性能评估采用了与之前发布的“Japanese Stable LM Alpha”相同的方法。评估包括了日本语言理解基准(JGLUE)任务,涵盖了句子分类、句子对分类、问题回答和文本摘要等八项任务。结果显示,尽管只有30亿参数,但“Japanese Stable LM3B-4E1T”在多项任务上表现出色,而“Japanese Stable LM Gamma7B”甚至获得更高的分数,展示了这些模型在日语自然语言处理方面的卓越进展。